Poucos assuntos são tão presentes em cada esquina das cidades grandes de hoje em dia e possuem tão pouca pesquisa quanto as drogas. Temas mais convencionais, já consolidados na agenda mainstream, possuem dezenas de trabalhos com réplicas e tréplicas para cada variável, enquanto no que tange às drogas a literatura ainda se encontra no “O que são, o que comem e onde habitam?”

A ilegalidade na qual as drogas se encontram apresenta um grande entrave para a elaboração de estudos robustos e sem achismos, uma vez que informações se tornam praticamente inexistentes. A coleta de dados é bastante complicada, de forma que poucos conseguem fazê-la – como em Venkatesh e Levitt (2000). Isso faz com que as pesquisas fiquem um pouco limitadas, mas não menos interessantes. Até o momento, a maior parte das pesquisas se concentrava nas consequências orçamentárias da legalização (Miron, 2005) ou em questões de saúde e consumo (Bretteville-Jensen e Jacobi, 2011; Jacobi e Sovinsky, 2016; Palali e Van Ours, 2014). A pesquisa a ser tratada no resto deste texto, por exemplo, visa avaliar a existência de influência de Coffee Shops no mercado imobiliário de Amsterdam.

Os recentes movimentos de descriminalização e legalização da maconha têm servido como ótimo cenário para diversas pesquisas na área, tanto por trazerem consigo dados antes não existentes quanto por também proporcionarem grupos de controle e choques exógenos, em meio às mudanças legais. Até o momento, cada país que legalizou a maconha o fez à sua própria maneira, com modelos de legalização bastante heterogêneos. Todos eles têm como base, porém, a noção de que existe uma certa heterogeneidade entre os consumidores de cannabis e que a maior parte dos malefícios sociais vem, na verdade, do próprio fato da droga ser ilegal.

Miron e Zwiebel (1995) lançam um olhar econômico sobre o mercado das drogas. Para eles, pode-se classificar os consumidores em duas categorias, os dependentes químicos e os de uso recreativo. Estes, segundo os autores, respondem às mudanças nos preços das drogas assim como o consumidor mediano responde a mudanças em preços de bens “convencionais”, enquanto aqueles terão uma demanda pela droga muito mais inelástica. Isto é, responderão muito pouco a mudanças de preços, uma vez que o importante é saciar a necessidade química. Do lado da oferta, uma vez que todos os agentes ofertantes estão na ilegalidade, não há como solucionar disputas na justiça, como cobrança de dívidas, por exemplo. Além disso, uma vez na ilegalidade, cometer outro crime possui um custo adicional muito menor e é nessa situação que a violência se torna uma ferramenta factível para quem está no mercado das drogas. A grosso modo, para Miron e Zwiebel (1995), os maiores problemas relacionados às drogas – violência e criminalidade, resumidamente – são, na verdade, consequências de sua proibição, e não do consumo.

Este estudo ilustra de maneira breve o entendimento sobre as drogas que as autoridades responsáveis na Holanda passaram a ter, na década de 70. Durante os anos 70, começou-se a entender que o mais importante não era impedir o consumo de drogas em geral, como se é feito em quase todos os países hoje, mas sim garantir que os usuários e a sociedade como um todo sofressem os menores danos possíveis. Tendo isto em mente, era necessário mudar de um paradigma de guerra às drogas para um de redução de danos, no qual o Estado assiste à população em vez de puni-la.

Para adaptar e organizar as instituições à essa nova política de drogas, primeiro classificou-se as várias substâncias em dois grupos, baseado no nível de risco à sociedade em geral. O grupo I, com drogas tais como cocaína e LSD, por exemplo, contempla as substâncias cujo risco é reconhecido como inaceitável; já o grupo II, que engloba cannabis, seus derivados e alguns analgésicos, é composto pelas substâncias cujo risco é dado como tolerável.

Uma outra maneira que os holandeses encontraram para melhor controlar a forma pela qual o consumo de cannabis no país se daria foi a criação dos Coffee Shops. Os Coffee Shops são, basicamente, lojas que possuem permissão para vender cannabis e seus derivados e devem seguir uma série de restrições, tais como não vender bebidas alcoólicas; não vender para menores de idade e não permitir o consumo de outras drogas dentro do estabelecimento. Segundo as leis do país, o prefeito de cada cidade é quem decide se algum Coffee Shop pode ser aberto ou se algum deve ser fechado, de forma que o estoque de Coffee Shops nas cidades é completamente controlado pelas autoridades.

Desde seu início, a política de drogas é regularmente reavaliada a fim de corrigir aspectos antes não considerados pelas autoridades. Diferentemente de outros lugares onde a maconha foi legalizada, na Holanda até hoje os ganhos econômicos não são o ponto principal da política vigente, mas sim diminuir os danos das drogas e incômodos ao público. Dessa forma, o crescente turismo de drogas que se instalou no país acabou sendo malvisto por muitos políticos, de forma a pressionarem por medidas que aumentassem as restrições às drogas em gerais, principalmente a cannabis.

Junto a esse motivador, alguns grupos entenderam também que era necessário tomar medidas para diminuir a exposição de menores de idade à cannabis e seus derivados – embora exista estudos apontando diminuição do consumo da droga entre jovens (Simons-Morton, 2010). Como consequência dessa pressão, alguns prefeitos julgaram prudente criar cadastros de usuários, para permitir que apenas residentes comprassem na cidade, e outros acreditaram necessário fechar Coffee Shops próximos a escolas.

A cidade de Amsterdam começou a acatar essas mudanças a partir de 2011, sendo que os primeiros fechamentos se deram a partir de 2014. Os fechamentos foram realizados em função da distância que o Coffee Shop se encontrava da escola mais próxima, não podendo ficar a menos de 500m. Essa medida culminou no fechamento de cerca de 20 lojas baseado somente na distância para alguma escola.

O fato de os fechamentos se darem apenas devido ao posicionamento de escolas fez com que o choque no estoque de Coffee Shops da cidade pudesse ser considerado completamente exógeno aos estabelecimentos, isto é, não relacionados a eles.

Na literatura, é comum procurar impactos no mercado imobiliário quando se quer avaliar se determinada amenidade possui externalidades positivas ou negativas. Neste caso, nosso trabalho procurou avaliar se os Coffee Shops exercem alguma influência sobre os preços de imóveis ao seu redor. Para isso, utilizamos dados de aluguel de Airbnb na cidade, de 2014 até 2017, junto com informações espaciais como distância para transporte público; para o centro da cidade; quantidade de atrações turísticas nos arredores; índice de criminalidade da região, entre outras amenidades. A variável de interesse é o fato de ter o Coffee Shop mais próximo ao imóvel fechado ou não. Em outras palavras, temos uma variável binária que é igual a 1 caso o imóvel tenha tido o Coffee shop mais próximo dele fechado e 0 para o caso de o Coffee Shop mais próximo ter permanecido aberto.

Nós utilizamos um modelo de efeitos fixos, como de praxe na literatura de economia urbana, para quando se tem dados em painel, de forma que é possível controlar por fatores não observáveis porém constantes ao longo do tempo. Em um primeiro modelo, utilizamos apenas o fato de o Coffee Shop mais próximo ter fechado ou não. Em seguida, utilizamos essa informação junto com o fato de ele estar a menos de X metros do imóvel – variamos essa distância X de 250m até 1500m. Essa variação nos permite observar como a influência se comporta em distâncias variadas.

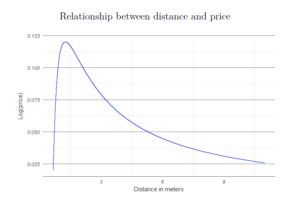

Nossos resultados mostram que ter o Coffee Shop mais próximo fechado fez com que os alugueis diminuíssem aproximadamente 2,5%, em média. Como é ilustrado na imagem, o fechamento de um Coffee Shop muito próximo possui uma influência significativamente maior no aluguel do que o fechamento de um Coffee Shop que se apresentava mais distante. O efeito do fechamento diminui de intensidade à medida que a distância aumenta até o ponto no qual deixa de ser significativo estatisticamente, para distâncias maiores de 500m.

Nossos resultados mostram que ter o Coffee Shop mais próximo fechado fez com que os alugueis diminuíssem aproximadamente 2,5%, em média. Como é ilustrado na imagem, o fechamento de um Coffee Shop muito próximo possui uma influência significativamente maior no aluguel do que o fechamento de um Coffee Shop que se apresentava mais distante. O efeito do fechamento diminui de intensidade à medida que a distância aumenta até o ponto no qual deixa de ser significativo estatisticamente, para distâncias maiores de 500m.

Este resultado é bastante interessante pois, ao contrário do que muitos pensavam, é possível que a maconha tenha externalidades positivas em um cenário micro em uma cidade. Obviamente, esta pesquisa possui limitações, pois apenas com ela não é possível saber com certeza como os mercados reagiriam em outras cidades, por exemplo. Além disso, não é claro como imóveis regulares – fora da plataforma Airbnb – reagiriam, uma vez que é discutível se esse resultado é consequência do maior uso do Airbnb por turistas ou não, de forma que seria bastante interessante fazer este exercício com dados de imóveis convencionais.

Mesmo com todas essas limitações, esse estudo contribui para o início da construção de um conhecimento mais robusto sobre as drogas que foge de achismos e se baseia em dados e evidências. Ainda há muito o que se pesquisar sobre o assunto e como os mercados e agentes reagem às mudanças para assim podermos criar políticas que realmente contribuam para um melhor bem-estar da sociedade.

Igor Koehne é mestrando em Teoria Econômica no Instituto de Pesquisas Econômicas/USP. Igor Koehne é mestrando em Teoria Econômica no Instituto de Pesquisas Econômicas/USP. |

Comentários