Existe o consenso segundo o qual, sob uma perspectiva de longo prazo, reverter a quase estagnação, nos últimos 30 anos, da renda per capita no Brasil passa por materializar aumentos de produtividade sem os quais a retomada do crescimento seria efêmera ou circunstancial.

Dentro desse contexto muito geral, a produtividade nos serviços ocupa, por diversos motivos, um lugar particular e mais polêmico. Várias são as circunstâncias que nutrem essa singularidade. Talvez a mais abordada na literatura diga respeito às potencialidades (ou ausência de potencialidades) do setor serviços, por características intrínsecas ao mesmo, em incrementar sua produtividade. No caso de assumir uma hipótese pessimista, o desfecho natural seria a denominada “doença de Baumol”, circunstâncias nas quais os salários setoriais se elevariam sem a correspondente elevação na produtividade, com desdobramentos nos preços relativos, inflação, etc. Já abordamos em outro post deste blog (https://bit.ly/2MWI36M) o caráter simplista e reducionista desta interpretação, uma vez que a sua construção requer assumir que os ganhos de produtividade estão concentrados, exclusivamente, na indústria de transformação. Abstraindo esta possibilidade, a questão da produtividade nos serviços volta a recolocar-se e integra um dos quesitos a ser pesquisado dentro do debate que tenta identificar os gargalos a serem superados para a retomada do crescimento. Nesse sentido, a literatura no Brasil é ampla e consensual (podemos citar, a título de exemplo, Arbache (2015), Veloso; Cavalcanti; Matos; Pereira Coelho (2016)): a produtividade dos serviços no Brasil acompanha a estagnação da produtividade da economia em geral e está situada em um nível bem distante do patamar dos países mais desenvolvidos e mesmo de nações com desenvolvimento mais próximo.

Contudo, a questão da produtividade nos Serviços não está, exclusivamente, associada às questões que dizem respeito ao longo prazo. Aspectos pertinentes ao ciclo de curto prazo também não estão dissociados das possibilidades de o setor de serviços elevar sua oferta mediante a utilização mais eficiente dos insumos. No recente ciclo inflacionário (2010-2016) uma particular atenção foi dada à alteração dos preços relativos em favor dos serviços e, na evolução de seus preços, era identificada uma das fontes do não cumprimento das metas inflacionárias (Arbache (2016)). A questão é complexa e não pode estar restrita a uma suposta inelasticidade da oferta no curto prazo.

Contudo, matizes estruturais e conjunturais podiam estar se agregando (Menezes Filho (2013)). A primeira década dos anos 2000, com suas especificidades (um ciclo histórico no qual o aquecimento era dinamizado pelo aumento do consumo, dos salários, especialmente os próximos ao salário mínimo, e dos benefícios sociais), pode ter tido um particular impacto sobre a demanda por serviços (Matos dos Santos et. al. (2018)). Lembremos, por outra parte, que uma elevada elasticidade renda da demanda de serviços seria uma característica do crescimento, independentemente da estratégia ser ou não wage-led growth (Clark (1957)).

Dessa forma, a questão da produtividade nos serviços se coloca tanto a partir de uma perspectiva de longo prazo (objetivo de elevar a renda per capita potencial) como de curto prazo (administrar um aquecimento do nível de atividade com mínimos impactos sobre os patamares de inflação). Inclusive, com a crescente incorporação na oferta da indústria de transformação de componentes oriundos dos serviços, a própria produtividade do setor industrial dependeria da eficiência do terciário (no mínimo de uma parte dele, aquele que o complementa).

Dentro desse contexto geral, um recente documento do Departamento de Pesquisas do Banco de Investimento Natixis (https://bit.ly/2EGniYu) introduz uma perspectiva original, uma vez que relaciona a produtividade do setor serviços com desemprego da força de trabalho com pouca qualificação e os indicadores de desigualdade. O referencial para a reflexão são dois países (Japão e França), dois modelos diferentes, sendo que em um (Japão) a produtividade dos serviços seria baixa e no outro (França) elevada.

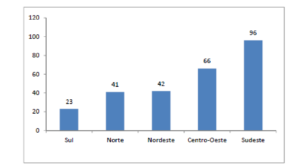

No caso do Japão, a produtividade na indústria de transformação seria tão elevada que sua competitividade não seria afetada pelo fraco desempenho dos serviços. Essa competitividade do setor secundário fica evidente quando o referencial é o indicador de saldo (positivo) do comércio de bens industriais com o mundo, que atinge 4,5% do PIB. O emprego industrial pode ser caracterizado como residual (15% dos ocupados), mas sua produtividade é crucial no equilíbrio do setor externo. Os salários do setor industrial são, em média, 20% superiores aos observados nos serviços.[1] Aqui, porém, temos uma hipótese não explícita na análise dos pesquisadores do Natixis: essa diferenciação entre rendimentos requer assumir que ou o mercado de trabalho é segmentado (hipótese plausível dada a forma de gerenciamento dos recursos humanos nas grandes firmas japonesas) ou estamos falando de qualidades de mão-de-obra diferentes (escolaridade/qualificação). A análise do banco sugere (implicitamente) que estamos diante de trabalhadores com capitais humanos diferentes, prevalecendo nos serviços um assalariado com baixa qualificação e, portanto, baixa produtividade. Assim, o setor de serviços seria intensivo em trabalho pouco qualificado ou sem experiência e, nessa perspectiva, as atividades terciárias se assemelhariam a “esponja”, absorvendo mão-de-obra não requerida pelo setor industrial e que poderia ser potencialmente vítima do desemprego. Os indicadores são, nesse sentido, eloquentes. A taxa de desemprego da PEA com 15 a 24 é de apenas 4,6% no Japão. Na França a mesma estatística assume um valor de 21,6%.[2]

Na medida em que, no país asiático, teríamos um mercado de trabalho diferenciado entre um espaço com bons empregos e elevada produtividade (indústria de transformação) e um outro com empregos de pouca remuneração e baixa produtividade, a dispersão de salários seria elevada. No Japão os assalariados com baixos rendimentos seriam quase 13% dos ocupados, na França 9%. [3] Esse fenômeno se aprofundaria no tempo na medida em que temos um setor com ganhos de produtividade dos quais se beneficiariam seus assalariados e um outro espaço com produtividade estagnada e fértil na geração de empregos.

Em termos mais gerais, a ineficiência nos serviços seria um “preço a ser pago” (um “imposto”) pela indústria de transformação para que a sociedade conviva com uma taxa de desemprego baixa ou, alternativamente, o “preço a ser pago” pelo setor industrial para a sociedade poder ofertar empregos que, não obstante serem de baixa produtividade, são aqueles que possibilitam absorver mão-de-obra com pouca qualificação. Uma vez que a produtividade na indústria de transformação japonesa é elevadíssima e crescente, sua competitividade externa (nos mercados mundiais) não estaria comprometida pelos custos a que é submetida.

No caso da França a lógica de funcionamento seria contrária: um setor de serviços muito eficiente, que não onera a indústria de transformação senão que complementa sua produtividade, sendo o custo uma elevadíssima taxa de desocupação daquelas pessoas com pouca qualificação. O percentual da força de trabalho francesa com menos de segundo grau completo que procura mas não acha um emprego é de 15,1% (2017), sendo de 10,8% a média dos países da OCDE. No caso dos indivíduos com ensino superior completo, a taxa de desemprego é de 4,7% (França) e 4,1% (média da OCDE). [4] Temos, assim, uma economia com elevada produtividade em todos os seus setores e que absorve mão-de-obra muito educada, sendo o ajuste realizado via taxa de desemprego da força de trabalho pouco qualificada.

Nesses casos, a desigualdade se alimenta pela qualidade do emprego (serviços), no caso do Japão, e pelo desemprego, no caso francês.

Essa discussão merece ser levada em consideração, no caso do Brasil, uma vez que, se as iniciativas para elevar a produtividade nos serviços chegam a se traduzir em resultados concretos, desdobramentos sobre a estrutura das taxas de desemprego e as desigualdades podem não ser desprezíveis. Logicamente, como sempre, seria interessante abrir o heterogêneo setor serviços entre aqueles nichos modernos, articulados com a indústria de transformação, integrantes dos circuitos mundiais de comércio, factíveis de incorporar as novas tecnologias, etc. daqueles subsetores associados a atividades para os quais as possibilidades de potenciais ganhos de produtividade são bem mais reduzidos e absorvem mão-de-obra com pouca qualificação. Seria interessante tentar identificar se nosso bom e velho trade-off entre equidade e eficiência não vai se insinuar por insólitas fendas.

Professor do Departamento de Economia, UnB. Graduação Universidad de Buenos Aires, Mestrado na Universidade de Brasília, doutorado na Université Paris-Nord. Professor do Departamento de Economia, UnB. Graduação Universidad de Buenos Aires, Mestrado na Universidade de Brasília, doutorado na Université Paris-Nord. |

Bibliografia Citada.

Arbache, J., Produtividade no Setor Serviços, in De Neri; Cavalcanti (2015)

………………, O Problema de Inflação de Serviços. Blog Economia de Serviços. 14/01/2016. (Disponível em: https://bit.ly/2LuIu49; consultado em dezembro de 2018)

Clark, C.,The Conditions of Economic Progress. London: Macmillian. 1957.

Fernanda De Negri, F.; Cavalcante, L.R., (Org), Produtividade no Brasil: desempenho e determinantes . Determinantes. v. 2. Brasília: IPEA. 2015.

Matos dos Santos, D.H., et.al. A natureza da inflação de serviços no Brasil: 1999-2014 Economia e Sociedade. v. 27, n. 1. p.199-231. 2018.

Menezes Filho, N., Educação, produtividade e inflação. Valor Econômico. 19/04/2013. (Disponível em: https://bit.ly/2rLNB7j; consultado em dezembro de 2018).

Veloso, F.; Cavalcanti, P.; Matos, S.; Pereira Coelho, P., “Produtividade do Setor de Serviços no Brasil: Um Estudo Comparativo”. FGV. 2016. (Disponível em: https://bit.ly/2T3IECo; consultado em dezembro de 2018).

- Fonte: Natixis/OCDE. ↑

- Fonte: Employment Outlook. OCDE. 2018. Os dados por nível de educação não são contabilizados para o Japão, uma vez que sua classificação (em termos de níveis de estudo) é particular e não possibilita uma comparação com os outros países da OCDE. Assim, utilizamos as faixas etárias para fins de confrontação e estamos supondo que as menores faixas etárias têm uma qualificação (dada pela experiência) menor. ↑

- Fonte: Employment Outlook. OCDE. 2018. Esses dados correspondem ao ano de 2016. Segundo a classificação da OCDE, os baixos salários são definidos como sendo aqueles que correspondem a 2/3 do salário mediano. ↑

- Fonte: OCDE. ↑

Comentários