O desenvolvimento das cidades se dá pelo acúmulo no espaço dos resultados sucessivos decorrentes de múltiplos e heterogêneos agentes que interagem entre si e com o seu meio. Nessas interações, indivíduos e empresas decidem estrategicamente suas ações mediando suas expectativas de pay-off com o conjunto de informações que os mesmos extraem do contexto onde estão inseridos.

Tais informações podem ser referentes às características e comportamentos dos demais agentes, à disponibilidade de recursos e as condições para acessá-los visando o alcance dos resultados desejados, às instituições (formais e informais) que regulam as relações sociais e econômicas da sociedade, às restrições impostas pelo meio físico (natural e construído), às forças políticas que atuam no ambiente, etc. Todas esses pedaços de informação se juntam formando um todo que configura um determinado espaço.

Uma característica dos agentes é que nas suas múltiplas rodadas de interação eles aprendem com a experiência, adquirem novas informações e modificam e adaptam suas estratégias e suas ações, o que produzirá cumulativamente no espaço novos resultados e novas informações, as quais, por sua vez, deverão ser processadas pelos agentes. Assim, na medida em que as cidades crescem, mais complexo se torna o ambiente, como nas regiões metropolitanas, ficando cada vez mais difícil o conhecimento e o processamento de todas as informações que o ambiente está constantemente produzindo.

Considerando a limitada capacidade do ser humano para processar quantidades gigantescas de informação, esse processamento é muito difícil também para aqueles que atuam no planejamento e na gestão das cidades, haja visto que elas podem evoluir tais como organismos vivos, muitas vezes sofrendo mutações no meio do caminho e mudando o curso do que foi planejado. Informação incompleta e planejamento baseado em tendências do passado que não necessariamente irão continuar no futuro muitas vezes produzem políticas públicas insuficientes ou inócuas para garantir um desenvolvimento urbano sustentável. Mudanças repentinas de rumo, em geral, não são bem aceitas pelos planejadores.

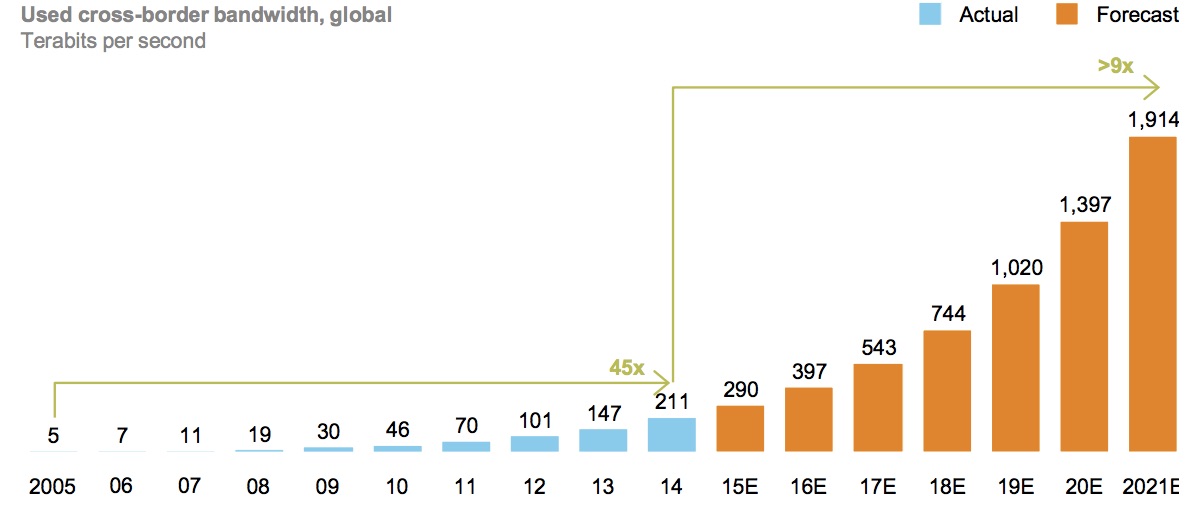

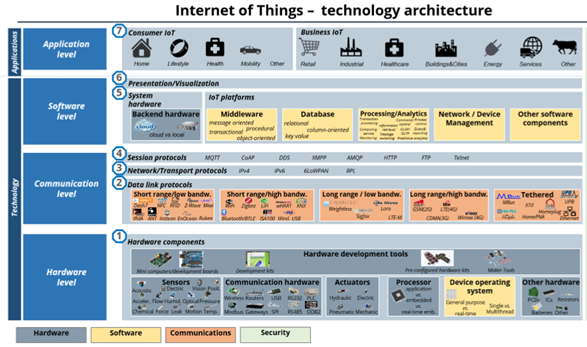

Ferramentas e sistemas digitalizados já são utilizados há algum tempo para tentar lidar com as informações relativas ao espaço urbano, cruzando dados georreferenciados, sobrepondo mapas, localizando infraestruturas, etc.; de modo a orientar a tomada de decisão no planejamento e na gestão das cidades. No entanto, as novas tecnologias digitais (internet das coisas, computação em nuvem, conectividade entre equipamentos, big data, inteligência artificial, internet de alta velocidade, etc.), tem oferecido um novo conjunto de soluções para lidar com a dinâmica da vida nas cidades, manejando um conjunto crescente de informações e elevando a um novo patamar o planejamento das cidades e a gestão na prestação de serviços públicos.

Por exemplo, o monitoramento em tempo real de atividades nas áreas públicas, de funcionamento de serviços públicos e o cruzamento simultâneo de informações de diversas fontes em bases territoriais oferecem a oportunidade para que o gestor público responda com mais agilidade a eventos fortuitos, tomando decisões mais seguras e rápidas.

Essas mudanças caracterizam, grosso modo, o surgimento das Cidades Inteligentes (Smart Cities) que, basicamente, podem ser descritas como cidades nas quais o aumento da capacidade de integração de dados e processamento de informações nos processos de planejamento e gestão das políticas públicas permitidas pelas tecnologias digitais, aumenta a eficiência e a eficácia na prestação de serviços à população e promove um desenvolvimento urbano mais sustentável. Certamente, o foco não é no uso da tecnologia em si, mas na utilidade que o seu uso gera para o cidadão, ao permitir que o poder público atenda as diversas demandas da sociedade com a utilização mais racional e eficiente dos recursos disponíveis, resultando na melhoria da qualidade de vida urbana.

O conceito de Cidades Inteligentes envolve mais elementos do que o simples uso de tecnologias digitais, desde que incorpora também noções de desenvolvimento sustentável, criatividade e inovação, cooperação e engajamento coletivo, participação social, parcerias público-privadas, difusão de conhecimento e co-criação em redes, novas abordagens de ensino e aprendizagem, ganhos de produtividade, clusters tecnológicos integrando indústrias e universidades, transparência e políticas de dados abertos, start-ups, etc. Por trás disso tudo está a organização do espaço físico e virtual tendo o conhecimento e o fluxo de informações como fatores de integração.

A incorporação de ferramentas tecnológicas digitais que permitem a utilização cada vez mais intensa das informações produzidas no dia-a-dia da vida urbana para atacar os principais problemas das cidades já é uma realidade em vários países, e cada vez mais intensa no Brasil.

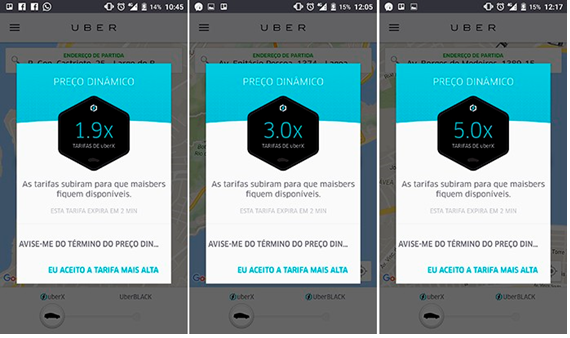

No mercado já existem tecnologias digitais para transportes e mobilidade urbana, mitigação de congestionamentos com informação de tráfego e navegação em tempo real, semaforização inteligente, cobrança eletrônica de pedágios, sistemas de compartilhamento de veículos, geração de energia renovável e eficiência energética, iluminação pública inteligente, sistemas inteligentes e automatizados de distribuição de energia, abastecimento de água, detecção de perdas e furtos do sistema de abastecimento de água, monitoramento da qualidade da água, monitoramento digital do descarte de lixo, otimização de rotas e coleta seletiva de resíduos sólidos, resiliência e segurança em espaços públicos, mapeamento de crime em tempo real, detecção sonora de disparos de armas de fogo, sistemas avançados de vigilância e reconhecimento facial, sistemas de alertas de emergência de eventos climáticos extremos, aplicativos de alerta pessoais e domésticos, engajamento comunitário e participação social, monitoramento ambiental (temperatura, emissão e redução de gases, umidade relativa, precipitação), dentre outras soluções.

A promoção das cidades inteligentes no Brasil tem crescido atraindo diversos players para o desenvolvimento de soluções para as cidades, o que exige mais investimentos na melhoria da infraestrutura de telecomunicações e internet de alta velocidade no país. Exige também, novas estruturas organizacionais e de governança no setor público. Pouco adiantará soluções tecnológicas integradas se ainda estiverem atreladas a ideias e instituições obsoletas, como a lógica organizacional hierárquica baseada em processos verticais excessivamente formais e burocratizados. Organizações constituídas de unidades autônomas organizadas em redes, adotando processos horizontais, mais ágeis e flexíveis, e soluções integradas por meio do compartilhamento de informações podem garantir melhores resultados na utilização das novas tecnologias digitais.

Cada vez mais o crescimento econômico estará atrelado ao acesso e utilização de informações nos processos produtivos. Indivíduos, empresas e o próprio setor público tomarão suas decisões a partir do processamento de uma quantidade quase infinita de informações o que demanda, além da mencionada melhoria da infraestrutura de IC, investimentos em capacitação.

A capacitação de pessoas já é estratégica, considerando o conhecimento necessário para utilização das novas tecnologias digitais, como utilizar as informações produzidas, a mão-de-obra disponível mais e mais envelhecida e o desaparecimento de algumas profissões com o surgimento de outras novas. Isso será fundamental para não ampliar ainda mais as desigualdades sociais, em especial nas áreas urbanizadas onde a maior parte do PIB é produzida e onde se encontra grande parte da pobreza, comprometendo o próprio desenvolvimento do país. A implementação de cidades inteligentes, no seu conceito mais amplo, será um imperativo cada vez mais forte para a atração de investimentos e mão-de-obra qualificada, para garantir uma maior qualidade de vida nas cidades e para a promoção do desenvolvimento sustentável.

|

Paulo Ávila é arquiteto e mestre em planejamento urbano pela Universidade de Brasília. Atua profissionalmente na área de planejamento urbano e regional, com ênfase em aspectos econômicos do espaço urbano. Foi professor no Curso de Arquitetura e Urbanismo Universidade Católica de Brasília. Atualmente é Analista de Infraestrutura lotado na Secretaria Nacional de Desenvolvimento Urbano (SNDU) do Ministério das Cidades onde coordena o Programa Nacional de Capacitação das Cidades. |

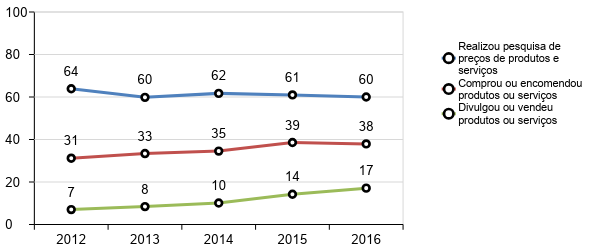

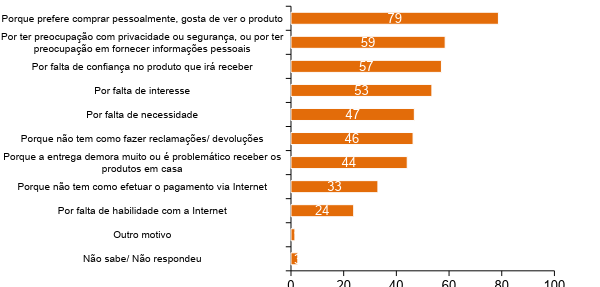

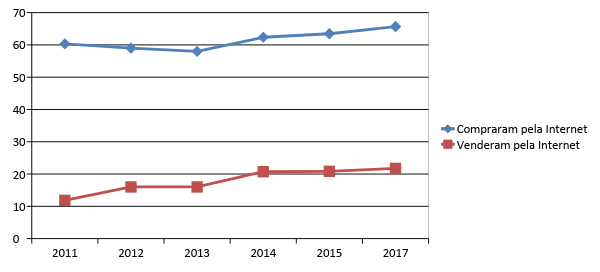

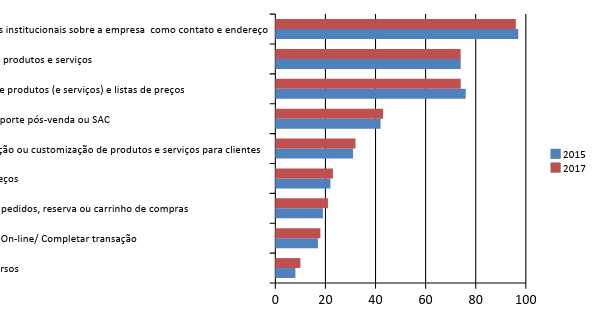

Fonte: TIC Empresas, 2017

Fonte: TIC Empresas, 2017

Comentários