A Vodafone, uma das maiores empresas de telecomunicações do mundo, publica, anualmente, o relatório “Vodafone IoT Barometer” para medir não só a percepção do mercado em relação à Internet das Coisas (IoT), mas para também avaliar os resultados práticos da adoção da tecnologia no mundo inteiro. O relatório de 2016 foi baseado em 1.096 entrevistas realizadas com empresas em 17 países (incluindo o Brasil).

Dentre os resultados apresentados, o relatório de 2016 dividiu as aplicações em seis grandes grupos que abrangem a maioria das soluções IoT, indicando o percentual de organizações que possuem ao menos um projeto em cada um destes grupos. O resultado é bastante significativo:

- 51% possuem projetos em otimização e monitoramento do uso de bens e veículos;

- 48% possuem projetos em automação predial;

- 46% possuem projetos em segurança e monitoramento de ambientes;

- 42% possuem projetos em automação de processos da cadeia de valor;

- 41% possuem projetos em novos produtos conectados;

- 40% possuem projetos em melhoria da segurança e sustentabilidade de espaços públicos.

Diante dos dados apresentados, uma das conclusões que se pode inferir do relatório é que estamos começando a entrar em uma segunda onda da Internet das Coisas. Na primeira onda IoT, a pergunta que todos se faziam era “o que eu posso conectar?” A ideia era simplesmente sair conectando “coisas” e avaliar o que fazia sentido e o que não funcionava. Nesta época surgiram ideias como a geladeira conectada, fechaduras e portas conectadas e a maioria dos wearables que vemos hoje.

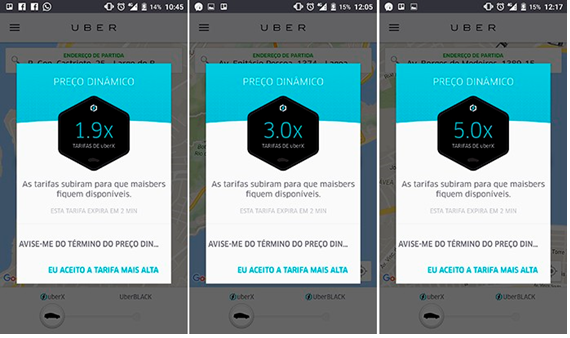

Na segunda onda IoT, que estamos começando a vivenciar, já se observam modelos de negócios orientados aos dados, não à conexão. Com isso, a pergunta certa a se fazer hoje passa a ser “quais os objetivos de negócio eu quero atingir e quais os tipos de dados eu tenho de coletar para alcançar esses objetivos?” As organizações hoje passaram a se perguntar o que elas precisam fazer para operar mais eficientemente e qual solução IoT é necessária para atingir esse objetivo. Com isso, a IoT passa a ganhar uma cara mais corporativa.

O grande fato relevante por trás disso tudo é que estes novos modelos de negócio tem um tema subjacente em comum, que pode ser resumido como “tudo-como-serviço” ou everything-as-a-service. Hoje já é possível observar projetos de economia de energia como serviço, por exemplo. A empresa americana ADT Security, do ramo de segurança e automação residencial, já oferece o produto de segurança como serviço, permitindo monitorar sua casa apenas durante o período de férias. A grande vantagem destes modelos é a massificação da tecnologia: ao comprar um serviço, o usuário evita fazer pesados investimentos para utilizar sozinho um serviço que pode ser compartilhado. Por outro lado, os prestadores de serviço passam a rentabilizar melhor a infraestrutura necessária para ofertar sua solução. Ganha o usuário, ganha o prestador de serviço, e ganham os desenvolvedores da tecnologia.

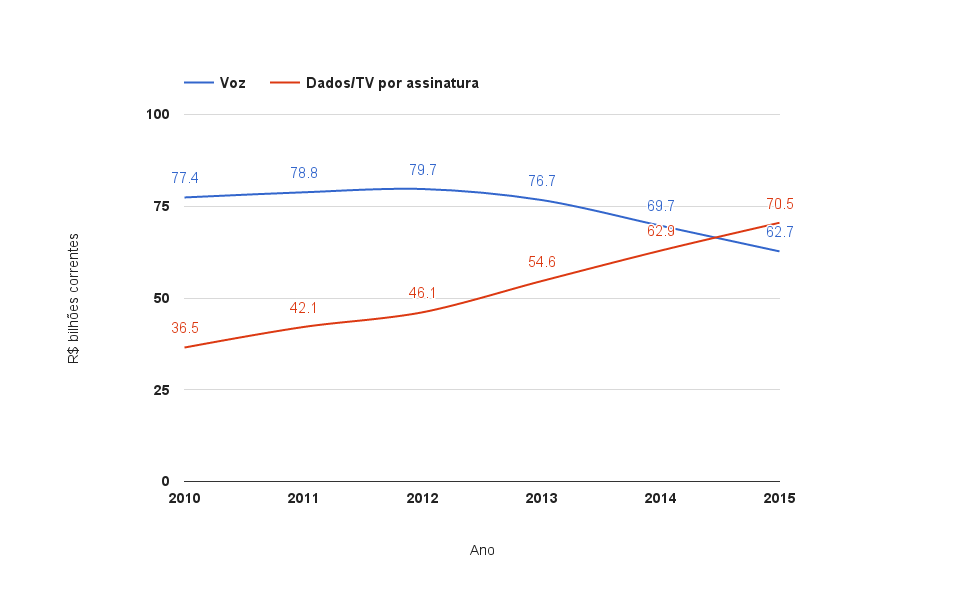

Olhando para o cenário interno brasileiro, a segunda onda IoT, com essa proposta de “servicificação” da tecnologia, pode ajudar na recuperação do nosso combalido setor de serviços, que vem sofrendo bastante com a recessão econômica dos dois últimos anos. Mais do que isso, esta segunda onda IoT pode ajudar a efetivamente desenvolver nosso setor de serviços, levando-o a um patamar maior de especialização, incorporando-o ao processo de produção e de negócios empresariais, e reduzindo o peso dos serviços de custo e de baixa especialização no nosso PIB.

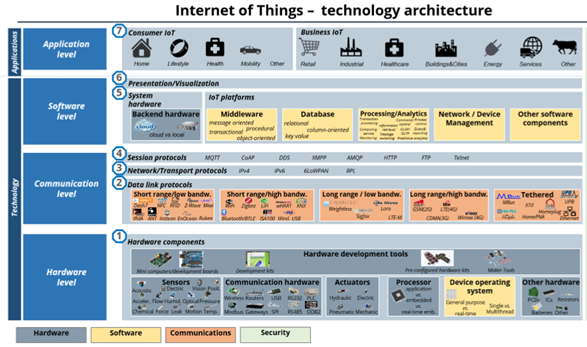

Enquanto o mercado IoT se apresenta como uma oportunidade multibilionária no mundo todo, o custo de entrada no negócio de desenvolvimento de soluções IoT pode ser surpreendente modesto em algumas ocasiões. Para entender onde estão estas oportunidades, precisamos lembrar como está organizado um ecossistema IoT. De maneira geral, esse ecossistema é composto por quatro camadas: são elas, “de baixo para cima”, hardware, comunicações, software e aplicações. A figura a seguir ilustra um ecossistema típico IoT, descrevendo as quatro camadas citadas.

Figura 1 – Ecossistema IoT (fonte: www.iot-analytics.com)

A primeira camada abrange os dispositivos físicos. É verdadeiramente a “coisa” da internet das coisas. Aqui encontramos sensores, processadores, termostatos e vários outros componentes que já existem há algum tempo, mesmo antes de ouvirmos falar da internet das coisas. Por estarem conectados à internet, estes dispositivos passaram a ter sistemas de defesa mais aprimorados para evitar o acesso indevido e ataques de hackers.

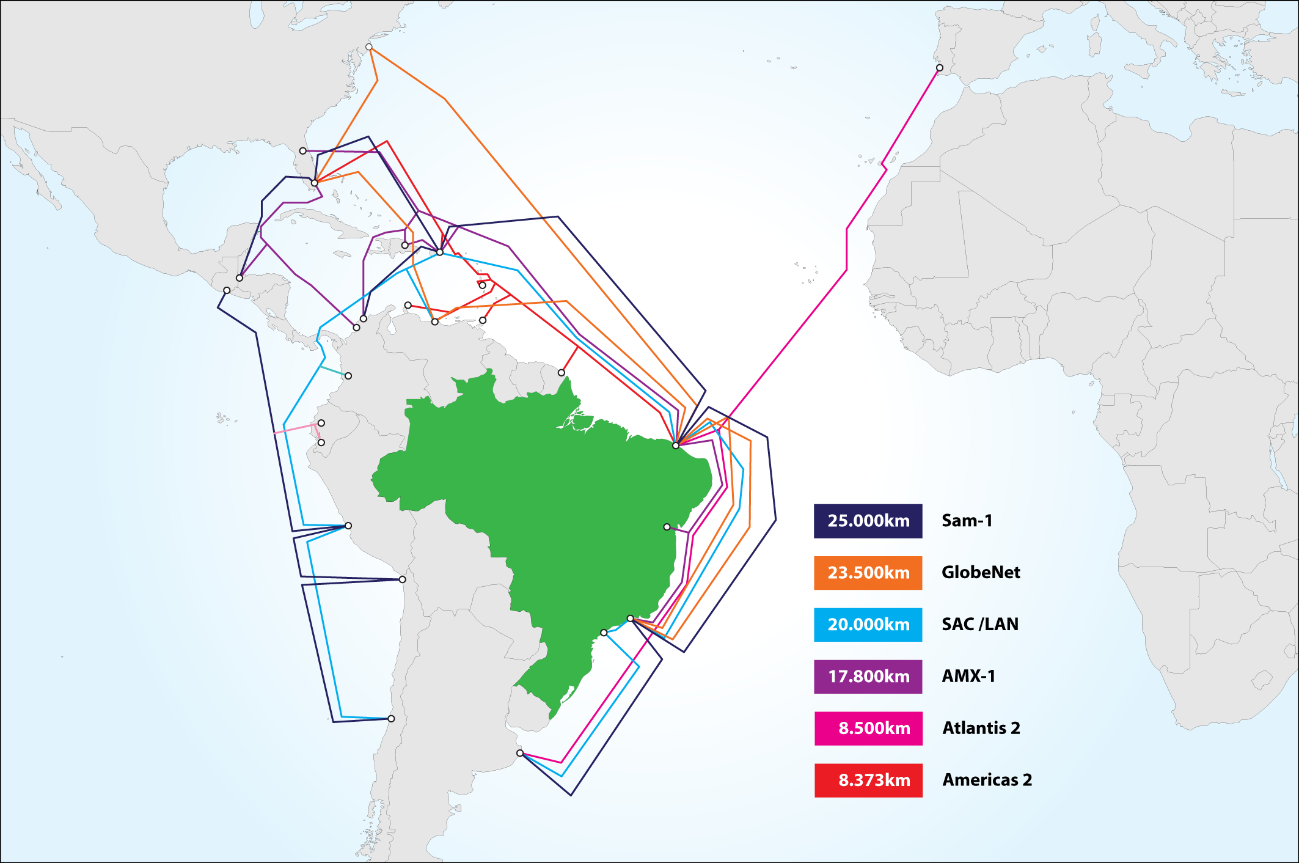

A segunda camada, responsável pelas comunicações, faz a coleta dos metadados associados ao serviço. A grande maioria dos protocolos são os mesmos já utilizados nas comunicações móveis e na internet comum. É nesta camada que estão, por exemplo, os padrões de comunicação como Bluetooth, Near Filed Communication (NFC), WiFi e LTE(4G). Aqui a padronização é essencial pois é por meio dela que dispositivos IoT irão “conversar” com sistemas de integração. Neste segmento, não se observam grandes oportunidades para novos players, especialmente porque estes componentes já são produzidos atualmente em cadeias globais de valor, principalmente pelos asiáticos, com grandes vantagens competitivas. Por mais que a retórica do recém-eleito presidente americano aponte em sentido contrário, dificilmente a “Doutrina Trump” vai conseguir reverter este quadro.

A terceira camada traz consigo todo hardware de backend e sistemas de integração. Aqui, todos os dispositivos IoT e seus metadados são agregados. É nesta camada que os desenvolvedores de aplicações IoT agregam seus dispositivos. Neste segmento, também não se observam grandes oportunidades para novos players. As barreiras de entrada são grandes porque os investimentos para se montar uma plataforma de agregação IoT são bastante elevados. Por precisar agregar centenas de milhares, às vezes até milhões de dispositivos, estes sistemas necessitam de alta capacidade de armazenamento de dados e de alta capacidade de processamento. Não por coincidência, as maiores plataformas do mercado hoje estão associadas a grandes empresas do mercado de Tecnologia da Informação e Comunicação (TIC). São elas: Amazon AWS IoT, IBM Watson, Cisco Cloud Connect e Microsoft Azure.

A última camada é composta por aplicações que agregam dispositivos e sistemas em uma solução para qual existe uma demanda específica. Uma aplicação de cidade inteligente, por exemplo, agrega as informações de câmeras de segurança, sensores de estacionamento, sinais de trânsito, frotas de veículos de transporte público e os transforma em informação relevante para um centro de gerenciamento integrado de serviços públicos, permitindo melhor monitoramento de uma cidade e de seus serviços e um melhor tempo de resposta para situações de crise. É nesta camada que está a grande oportunidade para novos players deste mercado, sobretudo de desenvolvedores e empresas nacionais, em virtude das baixas barreiras de entrada. Desenvolvedores de aplicações diversas podem passar a desenvolver aplicações IoT sem a necessidade de grandes investimentos. Além disso, a vantagem para o desenvolvedor nacional torna-se mais evidente se ele optar por explorar nichos de mercado tipicamente brasileiros. Peculiarmente diferente do resto do mundo em muitos aspectos, nosso jeito de nos comunicarmos, nosso sistema bancário e nosso governo são apenas alguns exemplos de nichos especialmente nossos.

Assim, por tudo isso, pode-se dizer que a nova onda IoT vem para incorporar de vez a tecnologia ao mercado corporativo. Já é possível imaginar que em um futuro próximo, ela será tratada como indistinguível dos processos de negócio das corporações e passará a ser vista como uma funcionalidade intrínseca de um moderno sistema de uma fábrica, de uma frota de carros ou de uma solução de segurança, por exemplo. Dentre os desenvolvedores de aplicações, vai sair na frente aquele que melhor conseguir identificar as oportunidades e necessidades das organizações e conseguir traduzir essa necessidade em uma solução de serviços que incorporem aplicações IoT funcionando como uma parte intrínseca do ambiente de negócios.

Comentários